Re: [新聞] AI真會重演.com泡沫?那場從1995一路

看板: Stock

作者: LoveSports (我要當一個渣攻)

標題: Re: [新聞] AI真會重演.com泡沫?那場從1995一路

時間: Mon Nov 24 09:30:42 2025

:

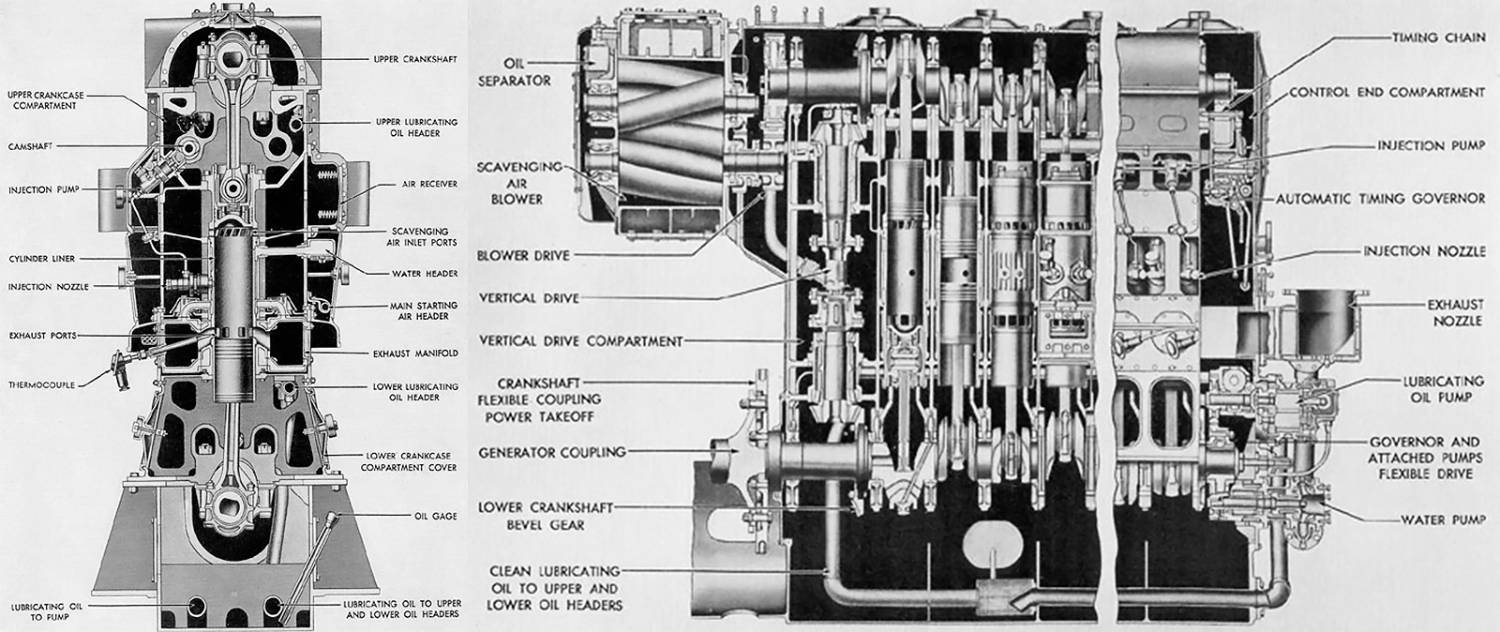

https://i.meee.com.tw/RLJsxew.jpg : 2.似乎更嚴重的邏輯錯誤:

: 「一個汽缸通常只有一個活塞,所以不會有『三個活塞間...」

: 既然都知道「通常」了,怎麼會接「所以不會有」呢?

: (正常的推理能力,應該會開始說各種奇怪的方案)

: ===

: 現在的AI繼續下去,也許是蠢蛋進化論的另一種實作方式?

: 2.似乎更嚴重的邏輯錯誤:

: 「一個汽缸通常只有一個活塞,所以不會有『三個活塞間...」

: 既然都知道「通常」了,怎麼會接「所以不會有」呢?

: (正常的推理能力,應該會開始說各種奇怪的方案)

: ===

: 現在的AI繼續下去,也許是蠢蛋進化論的另一種實作方式?

這是我用AI模式問的

要善用工具,要先了解工具的優缺點與屬性。

還有了解自己本身使用工具的能力(語言表達能力,主要是"認知學術的語言能力")。

這篇只針對前者討論。對後者有興趣的可參見這篇:#1f4-2kN3 (Gossiping)

先說結論:你挑AI模式測試,來論證LLM都是蠢蛋,這個前提就有問題了。

AI模式是Google搜尋的統整版,他的主要功能是在用戶做多重查詢時做整合,

方便用戶得到全面性的回答。

權重設定是放在精簡與全面性,而非深度搜尋。

你今天要查一個冷門的歷史上的技術性知識,拿AI模式來查會更難找到你要的答案。

這種情況還是問得出來(例如我上面貼的圖那樣),但是指示詞要下得比較精確。

例如:「歷史上所有的」、「輔佐的」、「請務必詳細搜尋與解釋」

如果你不想那麼麻煩,就請找LLM平台例如直接找Claude或Gemini或GPT或Grok,

LLM平台著重的是專業領域深度探討,你能更快甚至用更簡略的指示詞問到你的答案。

(我拿你的問題實測確認過了)

==================================================================

藉這篇宣導一下權重的重要性。

假設有一些滿腦子裝色情幻想的白癡,問的色情問題有扯到B&W,

類似的這類問題一多,而且色情用戶如果蠢到點讚,或一直問被判定是正向回饋,

下次系統更新的時候,AI的權重就會被改變,那些色情回答權重會變高,

相對的冷門專業技術性的權重就變小。

以後想問B&W相關問題的人,就越問不出專業技術性的答案。

所以為什麼宣導不要為了問色情問題越獄,因為越獄成功討到色情回答,

會影響到模型權重,其他用戶問問題就越問不出正確回答,指示詞得下得極度精確。

甚至更嚴重可能會導致安全層失效,間接造成LLM無法開啟安全防護保護脆弱用戶。

============================================================

最後補充一點,AI模式會把用戶在Google搜尋問過的問題納入個人化偏好參考。

如果用戶常在Google搜尋問生活化或粗淺的問題,AI模式也會偏向給同類型的答案。

平常問得越專業用字越嚴謹,他就會傾向幫你找冷門專業知識。

所以假如不想被當成蠢用戶,要定期檢查一下自已的google搜尋紀錄。

--

※ 發信站: 批踢踢實業坊(ptt.cc), 來自: 95.173.204.91 (日本) ※ 文章網址 ※